Balans bieli

Komentarz można dodać po zalogowaniu.

Zaloguj się. Jeżeli nie posiadasz jeszcze konta zarejestruj się.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

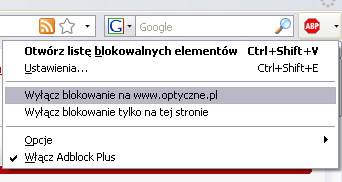

Będziemy wdzięczni, jeśli dodasz stronę Optyczne.pl do wyjątków w filtrze blokującym reklamy.

Z góry dziękujemy za zrozumienie.

Kliknij tutaj aby zamknąć to okno.

Komunikat nie wyświetli się więcej podczas tej sesji (wymagana obsługa cookies).

To kto zaczyna lament jakie to Sony jest do bani? ;)

:)

Sony umie tylko reklamować swój sprzęt. I idzie im to świetnie.

Taaa a nikon umie tylko wszystko od sony kupić bo sami jeszcze nic nie zrobili. A co to artykułu to bardzo fajny:)

W ostatnim akapicie jest napisane "fotografia nie zawsze musi służyć do pieczołowitego odzwierciedlania rzeczywistości. "

I z tym nie mogę się zgodzić. Kto tak twierdzi tworzy zamęt pojęciowy. Wtedy już diabli wiedzą co jego zdaniem jest fotografią. Kto coś takiego twierdzi ma obowiązek wskazać granice "majstrowania na obrazie rzeczywistości" po przekroczeniu których nie mamy już do czynienia z fotografią ale z czymś innym.

Jak zwykle ciekawy artykuł. Skoro podstawowe pojęcia dotyczące fotografii zostały poznane, to ciekawe o czym będzie następny artykuł?

Marian, daruj sobie.

@celluar

tak, kupuje i przy okazji pokazuje jak tego "uzywac" he he:) ale najlepsze do nikona sa obiektywy sony bo nikon sam jeszcze nic nie zrobil:)

artykul jak zwykle ciekawy, teoria tez sie przydaje a i nowicjuszowi pomoze:)

Marian znasz etymologię słowa fotografia? Zapewniam cię, ze nie ma tym nic o wiernym od wzorowaniu i fotografowaniu tablic testowych. Fotografia była, jest i będzie medium subiektywnym w całej swej rozciągłości, od aspektów techniczno optycznych na środkach wyrazu kończąc.

Tak więc daruj sobie takie wywody bo robisz młodszym wodę z mózgu ;)

Nie podoba mi się ta definicja światła:

"Z fizycznego punktu widzenia, na potrzeby niniejszej lekcji, możemy powiedzieć, że światło jest falą elektromagnetyczną o określonej długości. Fale o różnej długości postrzegamy jako kolory, co prezentuje poniższy rysunek."

Nawet dodanie "monochromatyczne" nie załatwia sprawy, ponieważ światło jest ZBIOREM fal o różnych długościach.

"Przedmioty posiadają kolory - ...". Nonsens. Barwa nie jest atrybutem przedmiotu a tylko sposobem postrzegania go w świetle odbitym o określonym spektrum.

Nie chcę dalej krytykować tej części o naturze i fizjologii światła. Uważam, że powinna być ona w całości przeredagowana przez optyka profesjonalistę w formie zlecenia. Nawet na tak podstawowym poziomie nie można wypisywać takich rzeczy.

"Rzadko mamy do czynienia z tak ciepłymi źródłami światła, by generowały one "chłodne" barwy." - a płomień gazowego palnika jest rzadki? A światło łuku elektrycznego przy spawaniu, lampy rtęciowe też są rzadkie? Ponadto słowo "ciepłymi" w powyższym zdaniu powinno być zastąpione "gorącymi".

W tym momencie przerwałem czytanie tekstu z powodu szkodliwości dla mojego zdrowia. Niech się inni wypowiedzą. Co za okropna klapa -- a tak świetnie szło!

ja nie jestem fizykiem (a może nie szukam dziury w całym), więc doczytałem do końca :). Niezły artykuł adresowany do wszysykich, tj. początkujących, kumających, a i zaawansowani technicznie fotografowie też mogą przeczytać bez uszczerbku na światopoglądzie.

@archangelgabrys - ja też zachodzę w głowę o czym będzie kolejny odcinek ;-)

Cedrys - rzeczywiście szkoda Twojego zdrowia bo najwyraźniej jest nieźle nadszarpnięte...

i jeśli Ty nie rozumiesz prostych zwrotów typu

- "na potrzeby niniejszej lekcji",

- nie kumasz, że aby coś prosto wytłumaczyć można spokojnie napisać, że przedmioty posiadają kolory, - albo jeśli fotografujesz w warunkach gdzie często źródłem światła jest piecyk gazowy, łuk elektryczny spawarki tudzież lampy rtęciowe (ile Ty takich fotografii w swoim schorowanym życiu wykonałeś :))

to ja Ci proponuję zmienić lekarza....

cedrys - troche zapominasz do kogo artykul jest adresowany.

o swietle optyk pisal w naszym innym artykule - link

ale obawiam sie ze gdybysmy cos takiego napisali w fotoszkole to nie cieszyla by sie taka popularnoscia.

"Przedmioty posiadają kolory - ...". - w artykule zostalo to wyjasnione, wiec nikt nie bedzie wprowadzony w blad z powodu takiego skrotu myslowego

Sony jest spoko i ma silny atut jakim jest Carl, to tyle w temacie lamentowania. O artykule... cóż - mocn oprzegadany. Balans bieli w fotografii cyfrowej sprowadza się do robienia zdjęć w RAW i osobnej korekcji tego parametru na komputerze oglądając zdjęcie na dobrym monitorze. Dla tych co lubią iść na łatwiznę zasada prosta : w słońcu to nastawiamy na "słoneczko", w cieniu to na "zacieniony domek" itp. Wszystko zostało powiedziane, reszta jest milczeniem.

niekoniecznie łatwizna. Ja pstrykam zawsze RAW+JPG. RAW jest dla mnie, ale zdjęć jest dużo i nie nad każdym oczywiście pracuję. JPG jest dla żony, po podłączy aparat do TV i widzi efekt natychmiast :). Przy sztucznym oświetleniu i innych nietypowych, jak np świece na nic się zdają ustawienia tematyczne typu: słoneczko, cień czy żarówka, i wtedy trzeba kombinować, żeby JPG wyszedł dobrze.

Kyniek - pierwsze czego uczą przy fotografii studyjnej to... przełączanie na RAW i ustawienie POPRAWNEGO balansu bieli.

Absolutnie nie masz racji - w RAWie są duże możliwości korekty balansu bieli, nawet bardzo duże, ale nic nie zastąpi poprawnie zrobionego zdjęcia. Kiedy zależy ci na oddaniu kolorów to możesz zapomnieć o swojej metodzie - żadna wywoływarka rawów nie zrobi tego co uzyskasz poprawnie definiując WB.

Sky_walker

z ciekawości dlaczemu ?

jaka będzie różnica w przypisaniu barwy pixelowi przed a po zrobieniu zdjęcia ?

Skróty myślowe w fizyce ? Cedrys ma absolutną rację - ciężko się to czyta. Czy nie prościej było wytłumaczyć powiązanie Kelvinów z barwą rozgrzewającej się stali ?

Wiechu: I znów byłoby nie tak, w definicji jest ciało doskonale czarne. Pytanie, czy tak opis jak w poradniku zmienia coś z praktycznego punktu widzenia? Chodzi o fotografowanie, a nie egzamin z fizyki.

Ech Optyczni, czemu Was nie było 30 lat temu kiedy zaczynałem przygodę z fotografią ;-)

Wielki szacunek i gratulacje za kolejny ciekawy i pożyteczny artykuł.

@wiercio:

Pewnie jest jak mówisz, mnie jednak trochę razi retoryka niektórych fragmentów tekstu i tyle. I wcale nie chodzi mi o egzamin z fizyki.

Sky_Walker - robię zdjęcia wyłącznie w RAWach i nigdy nie zdarzyło mi się, żeby były jakiekolwiek problemy przy ustawianiu balansu bieli w trakcie wywoływania. I zdefinicji RAWa wynika na mój gust, że ustawienie WB w aparacie nie ma żadnego wpływu na finalne zdjęcie, jakie otrzymamy po wywwołaniu go.

@rabusar

a cyrk to jest wtedy kiedy mamy kilka roznych zrodel swiatla w kadrze, np. naturalne wpadajace przez okna, swiece i zarowki, czasami (albo zazwyczaj) tak jest np. w kosciolach i potem trzeba troche poeksperymentowac na kompie:)

@Sky_walker dobrze się czujesz? RAW jest czystym zapisem z matrycy (raw po ang znaczy surowy) ustawienie balansu bieli jest jednym z parametrów dla JPG. Żaden normalny i świadomy człowiek nie będzie używał "jakiejś tam wywoływarki" tylko programów rzetelnych, np tych dostarczonych przez producenta aparatu ;) Jak masz parę źródeł światła o różnej temperaturze to se możesz ustawiać :P

Skoro tu tylu Fizyków, to może ktoś mi pomoże w odpowiedzi na następujące pytanie: Jaka jest natywna (niemodyfikowana cyfrowo) temperatura barwowa matryc cyfrowych?

OK, już wyjaśniam mój kłopot! - Chodzi o to przy jakim świetle surowy sygnał zarejestrowany przy fotografowaniu białej kartki nie będzie musiał być zmodyfikowany (proprcje składowych RGB), albo będzie modyfikowany w najmniejszym stopniu, aby tak uzyskany plik zdjęciowy przedstawiał również biel (czyli równy stosunek trzech składowych RGB)?

Śmiem twierdzić, że matryce cyfraków podobnie jak niegdyś filmy kolorowe charakteryzują się określoną temperaturą barwową oświetlenia przy której pracują najlepiej, z tą różnicą, że cyfrowo można mieć złudzenie większej uniwersalności sensora wynikającej z wygody pracy z komputerem i plikami kilkunastobitowymi (na każdy kanał RGB). Nawet mimo to w skrajnych sytuacjach oświetleniowych łatwo osiągnąć granice tej uniwersalności i im jej bliżej tym jakość oddania koloru jest niższa. Dlatego myślę, że warto by wiedzieć przy jakim oświetleniu modyfikacje barwowe plików surowych są najbezpieczniejsze.

W skrócie: Jaka jest (w przybliżeniu) natywna (per analogiam od "natywnej czułości") temperatura barwowa charakteryzująca matryce cyfrowe? 5500K? A może ktoś wie jak to zbadać?

Nie jestem Fizykiem ale sądzę, że mógłbym odpowiedzieć Ci na postawione pytania.

Matryca aparatu cyfrowego nie posiada żadnej "natywnej" temperatury barwowej. Tak jak wyjaśnia wyżej MatusP czy Kyniek, matryca rejestruje tylko surowy obraz widziany przez fotodiody przesłonięte filtrami mozaiki Bayera. To wszystko było świetnie wyłożone w poprzednich lekcjach tego cyklu. Tam też napisano jaka jest rola wzorca szarości 18% a także wiele innych ważnych rzeczy.

Podczas wywoływania RAW-a surowy obraz w postaci mozaiki zostaje zamieniony na obraz RGB wg schematu WB i profilu barwnego jaki miałeś ustawiony w aparacie, np. Standardowy. Jeśli Ci odpowiada ten schemat to możesz go zachować, następnie skorygować ewentualnie jasność czy kontrast i przekonwertować obraz do formatu DNG lub TIFF w zależności od tego czy dalszą obróbkę będziesz wykonywał w tym samym programie czy w innym, który Ci bardziej odpowiada. Możesz także zmienić schemat WB na inny jeśli stwierdzisz, że ten z aparatu Ci się nie podoba. Możesz także wskazać próbnikiem barw co Twoim zdaniem powinno być białe. I tu jest właśnie cały urok RAW-ów, dlatego opłaca się włożyć trochę roboty, żeby dostać to co lubisz. Dodatkowo oryginalne wywoływarki oferują skuteczne zmniejszanie winietowania, aberracji i dystorsji rozpoznawalnych obiektywów, zwiększenie ostrości bez zauważalnych artefaktów itd.

To o co podejrzewasz matrycę główną wykonuje czujnik pomiarowy, w różnych systemach różnie skonstruowany. U Nikona składa się z 1005 elementów, gdzie indziej z 63 lub tylko 35. Czasem jest jednowarstwowy czasem wielowarstwowy (7D) -- nieważne. Ważne jest to, że to on wykonuje robotę ustawiania optymalnego WB w zależności od sposobu pomiaru (matrycowy, centralnie ważony, częściowy, punktowy) we współpracy z bazą danych typowych sytuacji zarejestrowaną w pamięci aparatu a także "centruje" jasność obrazu względem wzorca szarości 18%.

Jeśli napisałem jakąś głupotę proszę mnie poprawić. Nie jestem alfą i omegą, każdy się uczy do grobowej deski.

Cedrys, dziękuję za trud, ale poza zaprzeczeniem w drugim zdaniu, że nie mam racji nie piszesz na temat. Ale nic to - przyzwyczaiłem się, bo nie pierwszy już raz zadaję to pytanie. ;)

Zwrócę tylko pokornie Twą uwagę, na to żeby nie traktować pliku surowego jak bezdennej czeluści, która w swej nieskończoności zawsze zawiera nadmiar informacji potrzebnej do dowolnego ich wywołania i to zawsze z najwyższą jakością. To niemożliwe. Przetwornik analogowo cyfrowy (liniowy i o skończonej głębi bitowej) zaraz "za" matrycą sprawia, że plik surowy ma dość wąski bardzo określony zakres przydatności.. I właśnie takie swoiste optimum owego zakresu odważyłem się pytać wcześniej...

Aha, żeby nie było... Przeczytałem wszystkie dotychczasowe lekcje i bardzo sobie chwalę! :) Z plikami surowymi pracuję nie od dziś i też bardzo sobie chwalę. :PPP Moje pytanie może nie jest gardłowe dla całej branży foto :P , ale myślę, że wskazuje na poważną lukę teoretyczną w sposobie wykładania zasad posługiwania się plikami surowymi w fotografii. Na tyle poważną lukę teoretyczną, że dotykającą praktyki!

ewg,

Spróbuję wobec tego inaczej ugryźć Twój problem. Najpierw zdefiniuję po swojemu znaczenie słowa "optymalny", żeby było wiadomo o czym mówię. Dla mnie optymalny znaczy "najlepiej radzący sobie z ograniczeniami" lub "najlepszy w konkretnej sytuacji".

Ograniczenia w kontekście stosowania RAW-ów to przede wszystkim prawidłowe naświetlenie -- to co podkreślił Sky_walker. Jeśli masz zdjęcie znacznie prześwietlone lub niedoświetlone to żaden RAW Ci nie pomoże. Drugim ograniczeniem jest głębia bitowa przetwornika A/C. Jeśli mamy przetwarzanie 14-bitowe, to uważam, że nie ma tu żadnego praktycznego ograniczenia, ponieważ matryca zwykle przetwarza około 8 EV, czyli 8 bitów. Żeby nie teoretyzować, zrób sobie konwersję RAW-a na TIFF 8-bitowy i 16-bitowy, następnie przekonwertuj oba na 8-bitowy JPEG, porównaj wielkość plików i ilość kolorów. Zobacz co otrzymasz. Dalej praktyka. Weź aparat, idź na dwór na śnieg oświetlony słońcem tak, żeby Cię raził. Nie zakładaj gogli, bo to niesportowo. Walnij parę sampli pod światło, bez przesady. Jaką dynamikę kontrastu ma obraz naturalny? Jaką dynamikę ma Twój monitor? 50 000:1? Ok, to niezły, bo to jest prawie 2 do 16-tej (65 536), czyli 16 bitów. Ponieważ wiesz, że matryca nie zarejestruje więcej niż 9 EV, musisz zdecydować co poświęcić: szczegóły w jasnych partiach czy w ciemnych. Teraz ograniczeniem jesteś Ty sam. Do wymienionych ograniczeń dodam jeszcze skończoną i niedoskonałą listę narzędzi edycyjnych w programie, który użyłeś, a także Twoją wiedzę jak się nimi posługiwać. Myślę, że ta lista ograniczeń to dopiero czubek góry lodowej, ale chyba nie możesz mi zarzucić, że nie piszę na temat. Mogę najwyżej nie rozumieć o co Ci naprawdę chodzi. Wtedy musisz tak skonstruować zapytania, żebym mógł zrozumieć, bo ja także mam ograniczenia.

Cedrys, mam wrażenie, iż założyłeś sobie od początku, że rozmawiasz z idiotą a przynajmniej fotograficznym ignorantem (może słusznie!). Dziękuję za zdefiniowanie słowa "optymalny" i za kolejną lekcję o poprawnej ekspozycji - zgoda!

Zatem skoro zgadzamy się co do optymalnej ekspozycji, tym samym potwierdzamy, że plik surowy nie jest z gumy, bo gdyby był ekspozycję możnaby ustawiać wręcz PO zrobieniu zdjęcia (w domciu, "na komputerze") - zupełnie tak jak to robimy z balansem bieli na plikach surowych. Z tą różnicą, że nad ekspozycją mamy kontrolę (migawka + światłosiła optyki/przysłona + wzmocnienie natywnego analogowego sygnału przed digitalizacją, czyli tzw. zmienne ISO) - a nad chrakterystyką kolorystyczną sensora już nie. Filtry RGB Bayera przed matrycą są tam przecież na stałe. Tak jak na stałe znajowały się na filmie kolorowym odpowiednie związki chemiczne oddające później kolor w ściśle określony sposób a prawdziwą biel jedynie przy konkretnym oświetleniu - co zresztą było jedną z podstawowych cech produktu (jak to zresztą opisano też w komentowanej lekcji). Gdybyśmy zeskanowali później taki film i zapisali go w ten sposób jako powiedzmy 16-bitowego tiffa, to mielibyśmy coś w rodzalu pliku surowego z matrycy, jaką stanowiłby film, tylko nawet lepszy, bo już przystosowany do ludzkiego postrzegania (o ile skaner by temu faktycznie sprostał) a nie liniowy jak typowy plik surowy z lustrzanki. Gdyby jednak oświetlenie w naszym skanerze miało inną (np. skrajnie inną) temperaturę barwową niż świato, dla którego ten film został przeznaczony (i jakim został później naświetlony), wtedy zawartość informacji o kolorze a przynajmniej niektórych z jego składowych mogłaby być uboższa lub nawet niektóre składowe mogłby zostać całkowicie odcięte/odfiltrowane.

Podobnie ma się rzecz z matrycą cyfrową. Przy pewnych rodzajach oświetlenia niektóre składowe barw mogą zostać całkowicie odcięte lub znacznie zubożone a późniejsze zapisanie tego nawet w pliku 100-biotwym nieczego tu nie zmieni, bo plik dalej będzie dla tej składowej koloru próżny. A z próżnego to i Salomon....

No tak, miałem uprościć... a wyszło jak zwykle... Bylo się już nie odzywać... Ok, dla mnie EOT. =)

ewg,

Wcale nie traktuję Cię jak ignoranta, gdyby tak było zignorowałbym Twój pierwszy post. Twoja ostatnia wypowiedź tylko potwierdza fakt, że znasz się na rzeczy. Z jedną rzeczą bym tylko polemizował. Napisałeś tak: "... a nad chrakterystyką kolorystyczną sensora już nie. Filtry RGB Bayera przed matrycą są tam przecież na stałe." Fakt, nie możemy zmienić charakterystyki matrycy, nie tylko barwnej, ale możemy to zrobić wcześniej projektując własne profile barwne. Słyszałeś o czymś takim jak Color Checker Pasport f-my Xrite? Jeśli nie to zapoznaj się. Powiedzmy, że wiesz o czym mówię -- wtedy fotografując w RAW-ch nie będziesz wybierał innego modelu barwnego niż ten, który wypracowałeś do aparatu. Po prostu klikniesz "wg ustawień". Edytor RAW-ów zastosuje Twój profil np. Portret_1 i ewentualnie zmodyfikujesz kontrast czy jasność wg własnego uznania. Możesz sobie zafundować profil Velvii 100 albo jakiegoś Kodaka, co chcesz.

ewg, cerdys

Każdy element światłoczuły (także komórka matrycy CCD czy CMOS) posiada pewną, być może nieliniową, charakterystykę pracy przy różnych częstotliwościach fali elektromagnetycznej. Nie można też lekceważyć wpływu elementów toru optycznego, przez który fale te docierają do komórki przetwornika.

Ciekawe, że nikt tego nie bada. Czy problem jest bez praktycznego znaczenia ?

Co do samego artykułu, to zastanowiły mnie także dwa jego fragmenty:

1. "Najczęściej spotykanym układem filtrów jest tzw. matryca Bayera"

Czy ktoś zna może inne układy filtrów barwnych stosowane w aparatach cyfrowych ? Pomijam tu matryce Foveon ze względu na warstową budowę.

2. "Tryb RAW ma również inne zalety. Ponieważ jest to sygnał, w który nie ingeruje oprogramowanie aparatu, to my mamy pełną kontrolę nad takimi procesami jak odszumianie albo wyostrzanie zdjęć".

Niestety, nie jest to prawda. Producenci często "upiększają" RAWy, o czym zresztą na optyczne.pl pisano już wielokrotnie. Jeśli o stajni Sony mowa : polecam chociażby test A700.

cedo - Z alternatyw dla filtru Bayera mamy wspomniany Foveon i filtr CYGM (między innymi Sony produkowało matryce w konfiguracji CYGM - CYGM oznacza Cyjan Żółty Zielony Madżenta).

Sony wymyśliło też coś takiego jak RGBE - matryce z kolorami jak w filtrze bayera i dodatkowym cyjanem - ale coś ten pomysł się nie przyjął (CYGM był znacznie popularniejszy).

Może jest coś jeszcze, ale nie słyszałem.

No i oczywiście masz racje - nie ma czegoś takiego jak RAWy w które nie ingeruje oprogramowanie. Nawet samo Sony pisze o tym w kilku miejscach na swojej stronie (nie wiem czy na polskiej wersji witryny też to jest, ale raczej tak :) ), nie mam pojęcia skąd ten pomysł u autora.

Kyniek, MatusP - gratuluje. Odrazu widać że eksperci od fotografii najbardziej krzyczą. Tak trzymać chłopaki! A teraz biegiem po książki o fotografii a nie tylko siedzicie i czytacie optycznych. ;)

Sky_walker : dziękuję.

Nawiasem mówiąc wcale bym się nie zdziwił, gdyby za jakiś czas ktoś "wyciągnął z lamusa" np. CYGM i przedstawił do jaki nowość mającą poszerzyć zakres tonalny.

cedo, Sky_walker,

Wg mojej wiedzy mozaika filtrów Bayera jest aktualnie najbardziej optymalnym rozwiązaniem pomimo jej wad. Nie zakończono zresztą eksperymentowania nad nią. Przykładem jest 7D Canona, gdzie jeden z zielonych filtrów rozjaśniono, aby poprawić charakterystykę szumową (kosztem częściowego oślepienia na kolor zielony). Podobne eksperymenty prowadził także Sony zastępując jeden z zielonych filtrów turkusowym. Po konwersji A/C (ang. D/A) sygnał jest już cyfrowy i kiedyś było tak, że rejestrowany był jako RAW, ale nie teraz. Dlatego informacja ta powinna być w powyższej lekcji skorygowana, gdyż wprowadza czytelników w błąd. Konwersja obrazu mozaikowego na obraz RGB jest obecnie bardzo szybka ze względu na coraz większe moce procesorów i nie ma się co dziwić, że się to wykorzystuje do wstępnej obróbki i udoskonalenia jakości RAW-ów. Osobiście nie widzę w tym nic złego. W końcu na czym nam zależy? Żeby format RAW był koszerny? Chyba nie. Po co mają wymyślać coś zupełnie nowego, skoro stare rozwiązania mają jeszcze potencjał rozwojowy? Nie zdziwiłbym się gdyby opracowano konwertery np. formatu CR2 na NEF lub odwrotnie i to przy różnych rozmiarach matryc. Jestem przekonany, że będziemy świadkami jeszcze nie jednego ciekawego rozwiązania. Postęp byłby szybszy gdyby nie ograniczenia patentowe a tak np. Foveon może umrzeć śmiercią na zasadzie syndromu psa ogrodnika. Rozumiem, że zdoktorowanie RAW-ów utrudnia Optycznym porównania, ale nas fotografów interesuje przede wszystkim efekt finalny nie porównania.

cedrys - oczywiście prawda, optymalnym rozwiązaniem na chwilę obecną jest filtr bayera i praktycznie wszystkie inne eksperymenty zakończyły się niepowodzeniem. Aktualnie pracują nad doskonaleniem filtra (np. Canon 7D) i samego stosunku sygnał/szum w sensorach (Super HAD 2, Exmor R, itp).

IHMO przyszłością są właśnie sensory podobne do Foveona - rozróżniające kolory na poziomie pojedynczych pikseli, bez bawienia się w zgadywankę. Pomysł raczej nie umrze przez patenty - wiadomo, że Sony eksperymentuje z wielowarstwowymi sensorami, a i inni producenci też w miejscu nie stoją. Najpewniej jeszcze daleka droga do sensorów wielowarstwowych które dawałyby tak dobry stosunek sygnału do szumu na wysokich czułościach co CMOS, ale już np. przy odwzorowaniu kolorów matryce te mają szanse znokautować obecne technologie i chyba tu zacznie się ich kariera - w fotografii studyjnej, aparatach pokroju Alfy 900 (czyli kiepskie wysokie iso, ale dobra charakterystyka pracy na ISO 100 i być może też wysoka rozdzielczość, jeśli komuś uda się pokonać ten główny problem Foveona). Pozostaje tylko zwalczyć niesmak po pustych obietnicach X3 i może wyjdzie z tego coś naprawdę ciekawego. No ale to raczej bardziej odległa przyszłość - na razie zostaje doskonalenie CMOSów (dla reporterki) i CCD (dla studia).

Swoją drogą - ciekawe jest jakie różnice powstają przy wywoływaniu RAWów - rozstrzał jakościowy między poszczególnymi programami bywa gigantyczny i (co ciekawe) jedne programy spisują się lepiej dla aparatów A a inne dla aparatów B. Więc jeśli ktoś ma czas to zachęcam do eksperymentów na własną rękę z wywoływarkami.

ewg: W zakresie widzialnym można powiedzieć że nie ma znaczenia. Fotokomórki są najbardziej czułe na promieniowanie niewidzialne, odcinane przez filtr IR przed matrycą.

Co do siatek to chyba fuji próbowało siatkę ośmiokątną stosować. W obecnych matrycach EXR stosuje specyficzną siatkę, pochodną Bayerowskiej

@Sky_walker pewnie czytałeś kupę książek o fotografii, szkoda że z praktyką i praktyczną wiedzą o RAW'ach tak słabo. Oczywiście najlepiej jest robić od razu zdjęcia z poprawnym ustawieniem. ALE jak się nie uda to bez jakichkolwiek konsekwencji balans można w RAW poprawić. Ba! Nawet w większości obecnych aparatów jest możliwość poprawienia balansu (i nie tylko) z poziomu aparatu po zrobieniu : Nikon i zapewne Pentax. Jeśli pominąłem jakąś zacną firmę i uraziłem fanów to przepraszam bo być może i nowe Canony i Sony posiadają taką opcję. Skoro jesteś taki mądry to wyjaśnij mi proszę czemu zdjęcie zrobione odrazu z poprawnym balansem miało by się jakkolwiek różnić od zdjęcia pozyskanego z RAW, nawet za pomocą opcji edycji w aparacie? Ja chętnie taką naukę przyjmę jeśli będzie wartościowa. Myślę że nie tylko ja ;)

Kyniek - przeczytaj jeszcze raz mój pierwszy komentarz w tym temacie, tylko tym razem: ze zrozumieniem, a dowiesz się dlaczego. Mogę ci nawet podpowiedzieć jeśli nie dotarło za pieszym razem: przeczytaj ostatnie zdanie 5 razy i użyj głowy. I wyobraź sobie, że z praktyką i wiedzą o rawach żadnych problemów nie mam.

Sky_walker - najwidoczniej masz problemy i nie tylko z wiedzą o RAW ale i emocjonalne. Po raz kolejny proszę byś mi wytłumaczył z jakiego powodu zdjęcie wykonane z poprawnym balansem bieli miało by się różnić od zdjęcia uzyskanego z RAW - żebyś nie nie pogubił sytuację uproszczę : Nikon D90, tryb JPG + RAW , następnie używasz opcji korekty balansu bieli w aparacie i tworzysz nowego jpg. Dlaczego miały by być różnice jakiekolwiek pod względem balansu bieli w tych zdjęciach?

Eh... kyniek kyniek... po co ja w ogóle z tobą gadam? No dobrze, pokażę ci wykład, ładnie przeczytaj - od A do Z i naucz się czegoś :) - wyjdzie ci na zdrowie i może przestaniesz mnie obrażać.

link

I zbastuj trochę. Ten sposób dyskusji możesz uprawiać na onecie, ale błagam: nie tutaj.

Eh... Sky_walker, to nie jest rozmowa bo po pierwsze w żadnym stopniu nawet nie starasz się zrozumieć co piszę a tym bardziej nie jesteś w stanie odpowiedzieć mi na proste pytanie. Pewnie myslisz że znasz temat lepiej niż inżynierowie Nikona i Canona... ok niech tak zostanie.

"Nikon D90, tryb JPG + RAW , następnie używasz opcji korekty balansu bieli w aparacie i tworzysz nowego jpg. Dlaczego miały by być różnice jakiekolwiek pod względem balansu bieli w tych zdjęciach?"

odpowiedź:

Gdy masz sesję i trzaśniesz 200-500 zdjęć to lepiej mieć dobry balans bieli na wszystkich, zamiast dostrajać ręcznie i tracić kupę czasu.

proste prawda?

albo ustawiasz wzór i stosujesz do tych 200 skoro oświetlenie się nie zmieni prawda ?