Nowa matryca Sony

ICX681SQW to oznaczenie nowej matrycy CCD opracowanej przez firmę Sony. Sensor o efektywnej rozdzielczości 14.2 Mpix (4352 × 3264 pikseli) i wielkości 1/2.3 cala (przekątna 7.791 mm) wyróżnia się niespotykaną do tej pory wielkością pojedynczego piksela, która wynosi zaledwie 1.43 μm.

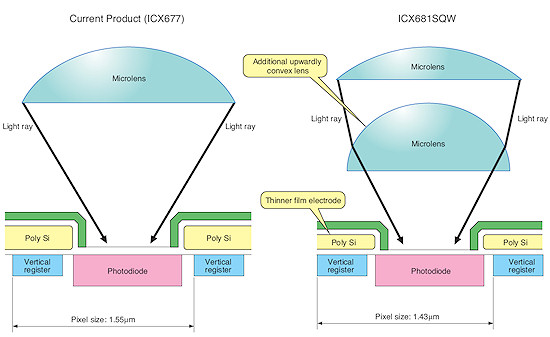

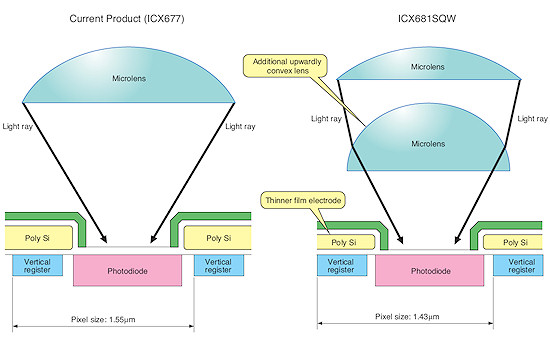

Taki wynik udało się osiągnąć dzięki zastosowaniu układu dwóch mikrosoczewek skupiających umieszczonych nad każdym pikselem. Inne procesy miniaturyzacyjne doprowadziły także do zmniejszenia poboru mocy o ok. 12% – spadek z 431 mW do 378 mW.

Schemat ilustrujący porównanie nowego sensora z tradycyjną matrycą z jedną mikrosoczewką nad pikselem. |

Matryca może rejestrować filmy wideo w rozdzielczości HD 720p, a także obrazy o wysokiej czułości w rozdzielczości 3.55 Mpix i przy prędkości 5.4 kl/s. W tym wypadku wykorzystuje się sygnał sczytany przez cztery sąsiednie piksele.

Nowy produkt znajdzie zastosowanie głównie w cyfrowych aparatach kompaktowych.

Komentarz można dodać po zalogowaniu.

Zaloguj się. Jeżeli nie posiadasz jeszcze konta zarejestruj się.

_443908423.jpg)

_968856305.jpg)

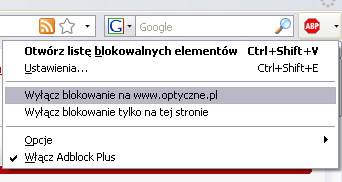

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

hmm.. a wydawało mi sie że im większy element na matrycy (mniejsza przekątna matrycy) tym mniejszy szum.

podejrzewam ze chodzi tu o to, iz uklad soczewek skupiajacych zbiera swiatlo z podobnej powierzchni co w przypadku starszych matryc (z jedna soczewka i pikselem 1.55 μm), ale dzieki mniejszemu rozmiarowi pikseli sa one luzniej ulozone na matrycy przez co oddzialywania miedzy nimi sa mniejsze.

Ciekawe jak się taką mikrooptykę wykonuje w procesie litograficznym. Z pewnością taki dwuelementowy kondensor jest sprawniejszy optycznie a ponadto można go ulepszać, np. korygując aberrację chromatyczną. Ciekawe również na ilu soczewkach się skończy i czy wymyślą zoom piezoelektryczny, gdzie będzie można soczewki przesuwać osiowo albo tilt przez pochylanie mikrosoczewek w narożnikach w zależności od zastosowanego obiektywu. W ciekawych czasach żyjemy. No, no -- viva Sony!

"Matryca może rejestrować filmy wideo w rozdzielczości HD 720p, a także obrazy o wysokiej czułości w rozdzielczości 3.55 Mpix i przy prędkości 5.4 kl/s. W tym wypadku wykorzystuje się sygnał sczytany przez cztery sąsiednie piksele. "

czekam na ta technologie w 40mp nastepcy a900.... 40mp dla detali lub 10mp dla wysokiego iso i szybkostrzelnosci...

co to za słowo "sczytany"?

gregg - link

a jedna z osob ladnie to wyjasnila w komentarzach w podanym linku:

"Czesto używane w informatyce jako określenie dotyczące odczytania pewnej kompletnej porcji danych związanej z jej umiejscowieniem na innym nośniku danych. Np. sczytanie zdjęć z aparatu, sczytanie z różnego rodzaju rejestratorów itp."

cedrys, w zasadzie nie ma znaczenia czy aberracja jest większa czy mniejsza, skoro całe światło pada na powierzchnię jednego piksela. Jak na jednym pikselu chciałbyś oszacować np. aberrację chromatyczną?

W praktyce zapewne okaże się, że ta matryca niczym szczególnym nie będzie się wyróżniac...

moze raczej zczytać? chyba ten kto to wymyslil zbyt wiele wczesniej nie "sczytal"

Matt, cz jest spółgłoską bezdźwięczną i dlatego poprzedzamy ją również bezdźwięcznym s. Jak nie lubisz zasad spraw sobie "NOWY SŁOWNIK ORTOGRAFICZNY" PWN.

amas, przestudiuj zasadę działania filtrów Bayera oraz proces demozaikowania obrazu a przekonasz się, że aberracja chromatyczna ma znaczenie. Już wcześniej na ten temat czytałem ale nie mam linka.

To może tak?

czytać => sczytać

czytać => fczytać :)))))) (zamiast wczytać) :))))

gregg- niestety nie masz racji.

tu chodzi o slowotworcze - spis, spisac i spisany / sczytac, sczytany.

Twoje wczytac i to inne slowo poniewaz nie istnieje samodzielnie jako "wczyt", zato zaistnialo samodzielnie jako wczytac. I dlatego dane wczytujemy.

sory za brak polskich zn.

wczyt

link

Panowie, starczy slowotworstwa. Wracamy do matryc

Sony chyba sczytuje .... a może szczytuje ... ?

;)

sorki nie mogłem się powstrzymać ;D

@cedrys - no to mi też wytłumacz, do czego miałaby służyć korekcja aberracji dla jednego piksela - i nie wiem czy chodzi Ci o korekcje aberracji pochodzącej z obiektywu (to miałoby jakiś tam sens, ale dla tak małego obszaru jak piksel , to chyba by się pryzmat przydał, a nie dwie soczewki), czy chodzi ci o korekcję spodziewanej aberracji z soczewek nad pikselem - a to wydaje mi się kompletnie bez sensu, bo po co. Przecież dla piksela Bayera chodzi tylko o natężenie światła, a nie o informacje o długości fali.

Jak dla mnie dwie soczewki są po to, aby skuteczniej załamać światło, dzięki czemu soczewki można przybliżyć bardziej do sensora - w końcu po coś ten "thinner film electrode" z rysunku jest "thinner" :)

Yura, gdyby chodziło o samo przybliżenie mikrosoczewki wystarczyłoby zmniejszyć jej ogniskową, co w efekcie dałoby miniaturę rybiego oka. Weź zrób eksperyment z silna lupą (jednosoczewkową) i umieść pod nią płytkę z zielonego szkła, następnie zogniskuj obraz słońca na okręgu powiedzmy 60% średnicy lupy. Zobacz jak równomierny będzie rozkład jasności na tej powierzchni. Fotosensory (zwane fotodiodami) mają różną konstrukcję: jedne podobnie do fotorezystorów mają postać meandra inne postać mozaiki. Nieważne jak są skonstruowane, ważne aby kondensor równomiernie oświetlał powierzchnię fotosensora, gdyż tylko wtedy zostanie wyłapana najdokładniej energia fotonów. Jeśli mikrosoczewka będzie miała aberracje chromatyczną to rozkład będzie nierównomierny i będą obszary "przepalone", jak na zdjęciu - a przepalone znaczy utracone bezpowrotnie. Na tym poziomie nie ma już RAW-ów. Długość fali ma oczywiście znaczenie.

Dalej nie rozumiem. Przecież piksel na matrycy, to kolektor - kawałek krzemu i nieważne gdzie uderzy foton, ważne że uderzy. Informacja jest zbierana na zasadzie jest / nie ma, a nie czy jest w środku, czy z boku.

Skoro jedna soczewka ma za zadanie "ścisnąć" światło tak żeby trafiało w detektor, a nie latało i obijało się po "infrastrukturze", to druga ma chyba to tylko usprawnić? Cały czas mi się rozchodzi po co druga soczewka, jak nie właśnie po to.

Yura, nie jest tak jak sobie wyobrażasz, dlatego nie pasuje Ci ta druga soczewka. Jeden piksel to studzienka fotonowa o rzeczywistych wymiarach i zdolności wyłapywania fotonów dochodzącej do kilku tysięcy. To nie jest abstrakt matematyczny punktu w przestrzeni euklidesowej. Dno tej studzienki przypomina powierzchnię nowoczesnego fotoogniwa a ściany boczne wykorzystują zjawisko całkowitego wewnętrznego odbicia. Spróbuj sobie wyobrazić gdy promień pada na tradycyjną silnie wypukłą mikrosoczewkę w narożniku, pod dużym kątem do osi optycznej. Częściowo przechodzi on przez nią i trafia na sąsiednią rozmazując obraz, co powoduje spadek rozdzielczości w narożnikach. Nowe rozwiązanie zmniejsza ten szkodliwy efekt. Sony wie co robi...

Ale piksel jedynie przetwarza sygnał świetlny na prądowy... ;)

Szabla, tak, bo to jest przetwornik jednej formy energii na drugą. Jak każdy przetwornik ma swoją sprawność i jest ona dużo mniejsza od 100%. Taką najprostszą formą są coraz popularniejsze ogniwa fotowoltaiczne.

Ostatnio zrobiłem sobie światłomierz do kontroli oświetlenia monitora podczas wywoływania RAW-ów. W Netto kupiłem dwa gadżety: jeża-latarkę z takim ogniwem o wymiarach 1"x1" (10 zł) oraz multimetr cyfrowy (25 zł). Jeża rozbiłem i wydobyłem z niego tylko to ogniwo. Po podłączeniu do miernika daje ono napięcie 0,1 V (za ciemno) do 2,2V (za jasno). Komfort to 0,7V - 0,9V. Przykręcając żaluzje ustawiam sobie to napięcie na 0,8V i wywołuję zdjęcia. Oczywiście dobrze jest jak monitor jest skalibrowany co jakiś czas. Jak ktoś ma więcej kasy może sobie takie urządzenie kupić gotowe. W efekcie zdjęcia wyglądają bardziej profesjonalnie, mają jednakową równowagę bieli.

cedrys, wyrażaj się trochę precyzyjniej, bo nie do końca wiadomo, o co ci chodzi. Jak twierdzisz, że nierównomierne oświetlenie powierzchni piksela (np. z powodu aberracji) może powodowac przepalenia, to coś tu jest nie halo. Przepalenie następuje, gdy czujnik (pixel) osiągnie limit swojej pojemności (wyrażanej w elektronach, czyli ładunek elektryczny). Fotony wybijają elektrony, pixel je zbiera i potem to jest czytane i przetwarzane. Skoro na światłoczułą powierzchnie pada tyle samo fotonów, tylko nieco inaczej rozłożonych, to "wyprodukują" one mniej więcej ten sam ładunek.

Podaj jakiegoś linka, jak masz informację o zasadzie działania detektora, bo chętnie poczytam i może się dokształcę.

amas, w internecie masz pełno artykułów na ten temat, ale jak to w internecie: są bzdury pomieszane z nieaktualnymi śmieciami. Weź np. taki: link

Wstaw do googla zapytanie studnia fotonowa a jak znasz angielski to photon well. Jeszcze lepsze są artykuły na stronach producentów, ale trzeba sobie zdawać sprawę z tego, że to wszystko jest popatentowane. Z kolei czytania opisów patentowych nie polecam. U Optycznych za szkolenie odpowiada dr Kokosa. Koniec tematu.

No i widzisz... czegoś takiego jak photon well nie ma... Zapewne chodziło o studnię potencjału, albo "electron well". Dlatego pisałem o precyzyjnym wyrażaniu się, bo to nie jest dyskusja o nowej fryzurze Dody, tylko ściśle techniczne sprawy.

amas, a to co?, niedowidzący: www.opticsinfobase.org › Optics Express › Volume 17 › Issue 15

A czytasz to, na co się powołujesz? Tam używają terminu quantum well. I tylko tego. Ta konwersacja zrobiła się już bezsensowna.

Wracając do artykułu - różnica w porównaniu z obecnymi matrycami z mikrosoczewkami jest taka, że powierzchnia zbierająca mikrosoczewki jest większa w stosunku do powierzchni piksela, i pewnie nie udało im się (albo nie opłacało) zrobić odpowiednio precyzyjnej/sprawnej pojedynczej mikrosoczewki, to zrobili dwie, a potem swoje robi już marketing.

Nie irytujcie mnie proszę tymi drobnomieszczańskimi dywagacjami o poprawnej polszczyźnie, kiedy mowa o zwrotach oczywistych:

nie ma wyrazu "sczytać" , nieważne jak bardzo byście chcieli. Jest to wyraz należący do gwary środowiskowej, czyli jest grypsem, powiedzonkiem, slangiem itd. Nie ma go w słowniku, chyba, że mowa o wydaniu podwórkowym. W tekście jest po prostu błąd, albo jak kto woli - pisany jest po części slangiem. To ta sama szuflada co "szkło" w przypadku obiektywu.

Jak się pojawi w powszechnych publikacjach zylion razy to może zostanie zaadaptowany. Puki co - JEST TO SLANG.

zamiast poprawić dynamikę to oni bawią się ze zmniejszaniem pikseli .... kiedy się doczekamy od SONY matryc które zamiast liniowo rejestrują logarytmicznie ... polecam wszystkim zainteresowanym zobaczy link ..... przetwornik .LINLOG ..eliminuje bolączki obecnych matryc ..możne to nie w temacie ale coś ciekawego zamiast bzdurnych soczewek nad soczewkami i małymi pikselami ...

www.photonfocus.com/html/eng/cmos/linlog.php

dżizas... ;))))