Dysk SSD dla fotografa

1. Trochę historii, trochę teorii

Jak to się zaczęło

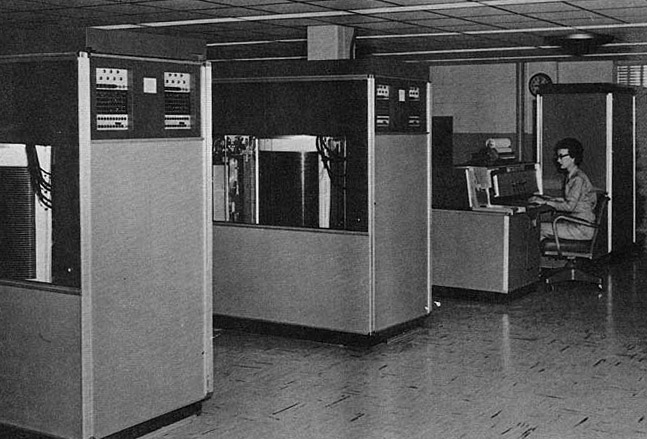

W pierwszej połowie lat pięćdziesiątych ubiegłego wieku nie było takiego problemu, bowiem nieliczne wtedy komputery bazowały na zupełnie innym nośniku pamięci – papierowych kartach perforowanych. W roku 1956 nastąpiła prawdziwa rewolucja, bowiem firma IBM zaprezentowała wówczas pierwszy dysk twardy, który został oznaczony symbolem 350 RAMAC. W jego przypadku największym zmartwieniem były rozmiary, waga i cena, a szybkość działania odeszła na drugi, albo nawet trzeci plan. Komputer IBM 305 z zamontowanymi dwoma dyskami IBM 350 RAMAC – to te szafy po lewej stronie. Źródło: Wikipedia |

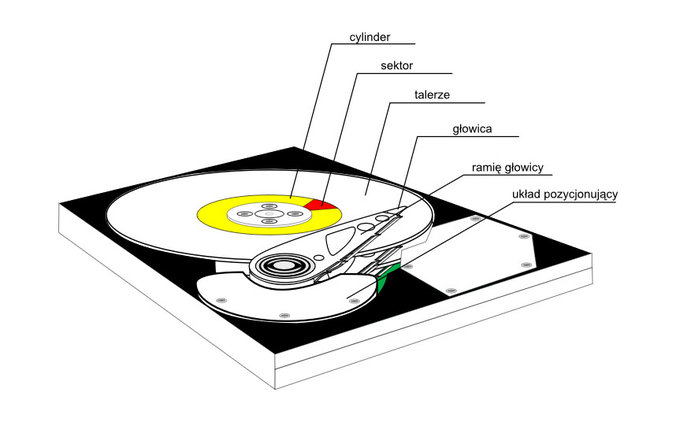

Pierwszy dysk zbudowany był na bazie 50 talerzy o średnicy 24 cali i posiadających w sumie 100 powierzchni do przechowywania danych. Talerze obracały się z prędkością 1200 obrotów na minutę, a na każdym z nich umieszczono po 200 ścieżek z danymi (po 100 na stronę). Do zapisywania danych służyła para głowic, która sterowana była przez serwomechanizm i poruszała się góra-dół w celu ustawienia przy odpowiednim talerzu oraz na boki w celu wyboru odpowiedniej ścieżki. Sam serwomechanizm nie był zbyt szybki, co skutkowało czasem dostępu do danych wynoszącym aż 600 milisekund, czyli nieco więcej niż pół sekundy.

Zasada działania tradycyjnego dysku twardego

Co ciekawe, współczesne dyski HDD (Hard Disk Drive) działają na podobnej zasadzie co IBM 350. Mimo upływu niemal 60 lat wciąż znajdziemy w nich obracające się talerze i głowice odpowiedzialne za zapis i odczyt danych. Obecnie w dyskach wykorzystuje się jeden lub kilka talerzy wykonanych z aluminium i pokrytych materiałem magnetycznym z dwóch stron (dwie powierzchnie do przechowywania danych). Każdy z talerzy jest wyposażony w zestaw 4 głowic elektromagnetycznych – po dwie na każdą powierzchnię, pierwsza odpowiada za zapis, druga za odczyt. Ramiona głowic są sterowane za pomocą cewki, która pozwala na precyzyjne ustawienie głowicy nad powierzchnią talerza. Schemat budowy dysku twardego. Źródło: Wikipedia |

Dysk twardy podczas pracy |

Nadchodzi SSD

Na szczęście z pomocą przyszły nowe technologie, które pozwoliły wyeliminować przestarzałe talerze z dysków twardych. W 1991 roku firma SanDisk zaprezentowała pierwszy 20-megabajtowy dysk SSD, czyli Solid-State Drive. Ciężko znaleźć polski odpowiednik dla tego określenia. Chcąc tłumaczyć to dosłownie otrzymamy „dysk w stanie stałym”, jednak osoba wymyślająca tę nazwę miała prawdopodobnie na uwadze fakt, że wszystkie elementy zastosowane w dysku SSD są nieruchome. W dysku SSD jako nośnik informacji wykorzystuje się bowiem pamięć typu flash znaną z używanych przez nas kart pamięci, czy pendrajwów. Półprzewodnikowe kości pamięci zostały tu połączone z kontrolerem zarządzającym procesem zapisu i odczytu danych, a z pomocą przychodzi odpowiedni bufor, który usprawnia ten proces. Ot cała filozofia dysków SSD. We wnętrzu dysku SSD nie znajdziemy już głowic i talerzy, ani innych elementów ruchomych |

Nic więc dziwnego, że zapisywanie i odczytywanie danych z dysków SSD może odbywać się dużo szybciej niż w przypadku tradycyjnego dysku twardego i bez problemów możemy osiągnąć tutaj prędkości na poziomie 500–550 MB/s, a także znacznie większe, co w porównaniu do 150–200 MB/s osiąganych w zwykłych dyskach jest znacznym postępem.

Oprócz dużo większej szybkości zapisu i odczytu danych, dyski SSD posiadają kilka innych zalet. Przed wszystkim są odporne na uszkodzenia mechaniczne. Tradycyjny dysk HDD po upadku w zasadzie nie nadawał się do użycia, gdyż mechanizm sterujący ramionami głowic jest bardzo podatny na uszkodzenia i nawet najmniejszy wstrząs potrafił go rozregulować. Z dyskami SSD nie ma takiego problemu, o czym przekonał się niemal każdy kto upuścił np. kartę pamięci lub pendrive. Zapewne do dziś działają one bez problemów. Brak ruchomych części i obracających się talerzy to także spory zysk w poborze mocy i obniżenie temperatury pracy. W rezultacie dyski SSD nie grzeją się, pobierają mniej prądu, a do tego pracują bezgłośnie.

Skoro dyski SSD są panaceum na całe zło związane z przechowywaniem danych, to dlaczego pojawiły się na rynku tak późno? Przecież pamięci półprzewodnikowe były znane już w latach pięćdziesiątych ubiegłego wieku. Największą przeszkodą w rozwoju dysków SSD od zawsze była cena pamięci półprzewodnikowych. Nawet dziś w przeliczeniu na 1 MB dyski SSD są około 10-krotnie droższe od tradycyjnych HDD. Jeszcze kilka lat temu ich cena była na tyle zaporowa, że sprzedaż stanowiła tylko niewielki promil w globalnym rynku dysków twardych, co z pewnością nie napędzało działów R&D w dużych firmach. Obecnie zakup dysku SSD o pojemności 100–300 GB w cenie kilkuset złotych nie stanowi problemu i z tego też powodu coraz częściej goszczą one w naszych komputerach.

W ostatnich latach znacznie dopracowano również żywotność pamięci półprzewodnikowych. W latach 90-tych ubiegłego wieku wytrzymywały one tylko około 10 000 cykli zapisu, co znacząco ograniczało żywotność dysku i dodatkowo nie zachęcało do zakupu. Obecne kości potrafią wytrzymać nawet milion takich cykli, a dodatkowo producenci na tyle udoskonalili kontrolery, że dbają one o to, aby cykle zapisu obywały się równomiernie na wszystkich komórkach pamięci. Dzięki temu unikamy sytuacji, w której po roku użytkowania dysku jedna z komórek ma za sobą 10 000 cykli zapisu, a inna ani jednego.Szczególnie mocno wytrzymałość dysków SSD akcentuje producent marki SanDisk, gwarantując że użytkownik po dłuższym czasie użytkowania dysku nie odczuje spadku jego wydajności.

Skoro jesteśmy przy temacie żywotności komórek pamięci półprzewodnikowych, to warto wspomnieć o jeszcze jednej zalecie dysków SSD. W przypadku uszkodzenia takiej komórki wciąż możemy odczytywać z niej dane, lecz już nic nowego w niej nie zapiszemy. Dzięki temu unikamy problemu, który dotyczy tzw. „bad sektorów” w tradycyjnych dyskach talerzowych. Poza tym podczas formatowania dysku taka komórka zostanie oznaczona jako uszkodzona i nie będzie więcej wykorzystywana przez kontroler.

Brak głowic w dysku SSD implikuje jeszcze jedną przewagę nad HDD. Jak wiemy, tradycyjne dyski twarde zmniejszają swoją wydajność wraz z ich zapełnianiem. Jest to spowodowane tym, że pliki zazwyczaj nie są zapisane w sąsiednich sektorach na talerzach, a często są rozdzielane na wiele fragmentów, a każdy z nich znajduje się w innej grupie sektorów, czyli w innym miejscy na talerzu. W rezultacie chcąc odczytać taki dysk głowica musi przeskakiwać z miejsca w miejsce, co spowalnia proces odczytywania danych. Gdy dysk jest mocno zapełniony, kolejne zapisywane pliki są coraz bardziej rozdzielane, a poszczególne fragmenty coraz bardziej „rozrzucane” po powierzchni talerza. Z tego też powodu, im więcej danych znajduje się na HDD, tym wolniej są one odczytywane. W takim przypadku pomaga defragmentacja, czyli proces polegający na takim przesuwaniu poszczególnych części plików w obrębie dysku, aby znajdowały się one w swoim sąsiedztwie. Przyspiesza to proces odczytu, lecz niestety defragmentacja, choć pomocna, to jest czasochłonna, a do tego jej efektywność spada wraz z zapełnianiem się dysku. W przypadku SSD problem ten w ogóle nie istnieje. Kontroler nawet specjalnie rozrzuca fragmenty plików na różne kości pamięci, gdyż odczytywanie trwa szybciej, gdy odbywa się z kilku układów jednocześnie. Zatem nawet mocno zapełniony dysk SSD nie straci nic na swojej wydajności, a jakby tego było mało nie musimy przeprowadzać mozolnej defragmentacji.

Obniżenie cen produkcji pamięci flash i zwiększenie ich żywotności sprawiło, że dyski SSD stały się kuszącą alternatywą dla tradycyjnych HDD. Choć mając na uwadze ich pojemność wciąż są znacznie droższe od swoich odpowiedników w ofercie HDD, to wymienione tu zalety sprawiają, że technologia ta zdobywa ogromną popularność. Czy zatem miłośnik fotografii powinien rozważyć zastosowanie dysku SSD w swoim komputerze? Na to pytanie odpowiemy w kolejnym rozdziale.

_1877607562.jpg)

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.