Sony A7R IV w naszych rękach

Komentarz można dodać po zalogowaniu.

Zaloguj się. Jeżeli nie posiadasz jeszcze konta zarejestruj się.

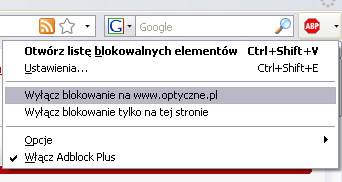

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Będziemy wdzięczni, jeśli dodasz stronę Optyczne.pl do wyjątków w filtrze blokującym reklamy.

Z góry dziękujemy za zrozumienie.

Kliknij tutaj aby zamknąć to okno.

Komunikat nie wyświetli się więcej podczas tej sesji (wymagana obsługa cookies).

@Redakcja

"U poprzednika, jego działanie polegało na wykonaniu 4 ekspozycji i złożeniu ich potem w kompozytowy obraz o podwyższonej rozdzielczości."

Bzdura. U poprzednika rozdzielczość wyjściowa w trybie pixel shift była taka sama jak natywna matrycy, a 4 ekspozycje były składane celem uzyskania pełnej informacji RGB dla piksela wyjściowego, natomiast nie powodowały wzrostu rozdzielczości wyjściowej. Tutaj dodano 4 przesunięcia po pół piksela przy każdym przesunięciu o 1 piksel, stąd mamy 16 ekspozycji i wzrost rozdzielczości wyjściowej przy jednoczesnym składaniu RGGB.

No to przecież jest podwyższona, bo każdy piksel niesie informację :) Dodam słowo "efektywnej", żeby było jasne.

Wizjer - identyczny z tym z S1 - to Sony ECX339A link

@Arek

"No to przecież jest podwyższona, bo każdy piksel niesie informację :)"

Nie filozuj, bo dobrze wiesz o co chodzi. Pixel shift w Pentaksie czy Sony (do A7r III włącznie) nie podnosił rozdzielczości wyjściowej obrazu, w przeciwieństwie do działania tego trybu w Olympusie czy Panasoniku.

A jeżeli chcesz się bawić w semantykę, to równie dobrze można powiedzieć, że w każdej specyfikacji technicznej aparatu wprowadzacie czytelnika w błąd, bo przy pozycji "dostępne rozdzielczości" powinno być "zależnie od obiektywu oraz pozostałych czynników wpływających na przeniesienie detalu".

Nie piszecie nic o obsłudze dotykiem. Jest w końcu, czy nadal tylko AF?

sigma z niecierpliwością czeka na rozstrzygnięcie sporu o rozdzielczość między mate i Arkiem bo teraz nie wie jak reklamować swojego zapowiadanego foveona - 60 czy 20 mpix? ;-)

@tempor: na szczęście, pozostało tak, jak było.

mate - nie filozofuje i dobrze wiem o co chodzi. Maciek zastosował skrót myślowy, który po dołożeniu słowa "efektywnej" prawidłowo oddaje sytuację bez wdawania się w szczegóły. EOT.

@Szabla

"Na szczęście"? Jaja sobie robisz? Po Z7 nie wyobrażam sobie, by w studiu pałować przyciski zamiast od razu wybrać potrzebną opcję na ekranie.

Sony chyba źle zrozumiało przekaz kampanii "Zły dotyk".

@tempor: miziaj sobie, jeżeli chcesz. :)

A jaki wplyw na cene 7r3 bedzie miala ta premiera? Czy zejdzie ponizej 10 tys? I oczywiscie na inne jeszcze tansze modele?

A kiedy nastepca 7s2 ?

Czy w trybie "full frame" da się robić RAW o mniejszej rozdzielczości?

Wymuszając tryb APS-C.

Da się przeciez włączyć kompresję.

sorry, źle doczytałem, głupia odpowiedź z mojej storny, prosze o skasowanie ;)

@Szabla: ale w trybie APS-C mam już inny przelicznik ogniskowej. A mnie np. chodzi o zdjęcie np. na najszerszej posiadanej ogniskowej.

Z to co wiem, to nie.

mate

17 lipca 2019, 09:49

@Redakcja

"U poprzednika, jego działanie polegało na wykonaniu 4 ekspozycji i złożeniu ich potem w kompozytowy obraz o podwyższonej rozdzielczości."

Bzdura. U poprzednika rozdzielczość wyjściowa w trybie pixel shift była taka sama jak natywna matrycy, a 4 ekspozycje były składane celem uzyskania pełnej informacji RGB dla piksela wyjściowego, natomiast nie powodowały wzrostu rozdzielczości wyjściowej

-------------------------------------------------------

wlasnie ze powodowaly ,

rozdzielczosc obrazowania , czyli rzeczywista liczba rozroznialnych detali obrazu to na matrycach RGB ok. 50 - 60 % calkowitej liczby pixeli matrycy.

( przykladowo na matrycy 24 mpx na obrazie mozna rozroznic np 12 mp roznych detali)

dzieki temu trikowi sony, zastapiono interpolowane wartosci RGB rzeczywistymi , dzieki czemu rozdzielczosc obrazowania wzrosla mimo tej samej liczby pixeli matrycy . Tzn np zamiast 50 % w klasycznym RGB z interpolacja byc moze teraz bedzie 70 %. Dzieki temu uzyskano wyzsza sprawnosc optyczna ukladu. Rozdzielczosc obrazowania wzrosla , tzn na obrazie o tej samej liczbie pixeli jest teraz wiecej zapisanych detali.

Ale rozdzielczość rozumiana jako całkowita ilość pikseli się nie zmienia.

RAWy to ze 100MB chyba mają, ciekawe jak z celnością AF-C

117 MB.

Szabla

17 lipca 2019, 21:10

Ale rozdzielczość rozumiana jako całkowita ilość pikseli się nie zmienia.

--------------------

trzeba rozrozniac pomiedzy rozdzielczoscia matrycy a rozdzielczoscia obrazowania.

optyczne pisza o rozdzielczosci obrazu.

przy tej samej liczbie pixeli rozdzielczosc obrazu wzrosla.

nie mozna napisac , ze jest to bzdura.

slowo "rozdzielczosc" bywa uzywane wlasciwie w dworch roznych znaczeniach - jako formalna liczba pixeli z ktorej zbudowany jest obraz , ja uzywam chetniej " wielkosc obrazu"

- jako liczba/ wielkosc rozroznialnych elementow - wynikajca z rozmycia obrazu. Te rozdzielczosc mierza optyczne w swoich pomiarach.

dotychczasowy pixelshift ma za zadanie zwiekszenie rozdzielczosci obrazowania przy niezmiennej wielkosci obrazu. Rozdzielczosc optyki w tym zabiegu nie musi byc wieksza. Chodzi tylko o wyeliminowanie interpolacji RGB.

( w rzeczywistosci naswietlajac wielokrotnie nawet bez shift i skladajac obraz nastapi poprawa rozdzielczosci obrazowania , ale to jest chyba pomijalne. Stosowano juz w czasach analogu )

Jesli pixelschift jest realizowany przez naswietlenie z przesunieciem matrycy o wielkosc pomiedzy pixelami , to oczywiscie rosnie wielkosc i rozdzielczosc obrazu . rozdzielczosc optyki jest tu ograniczeniem . Nalezaloby robic shift wraz z obiektywem , albo stosowac optyke o wyzszej zdolnosci rozdzielczej.

@Arek

To przysuwanie kojarzy mi się bardziej z nadpróbkowaniem w celu powiększenia rozdzielczości przetwornika cyfrowego jakim jest matryca. Nie wydaje mi się, aby przesuwanie matrycy było aż tak dokładne - 0,5 pixela. Wystarczy przesuwanie przypadkowe. Im więcej, tym większa rozdzielczość

@barnaba

"Nie wydaje mi się, aby przesuwanie matrycy było aż tak dokładne - 0,5 pixela."

No to niech ci się zacznie wydawać, bo tak jest. Są 2 rodzaje przesunięć, jedno o 1 piksel, aby w danym punkcie rzutowanego obrazu dostać naświetlanie z RGGB, oraz przy każdym przesunięciu o 1 piksel są dodatkowo 4 przesunięcia o 0,5 piksela w każdą stronę, celem zwiększenia rozdzielczości wyjściowej pliku.

barnaba

18 lipca 2019, 09:59

@Arek

To przysuwanie kojarzy mi się bardziej z nadpróbkowaniem w celu powiększenia rozdzielczości przetwornika cyfrowego jakim jest matryca. Nie wydaje mi się, aby przesuwanie matrycy było aż tak dokładne - 0,5 pixela. Wystarczy przesuwanie przypadkowe. Im więcej, tym większa rozdzielczość

------------------

wystarcza przypadkowe , czyli powtarzanie zdjec bez poruszenia aparatem , nigdy nie uda sie rzeczywiscie bardzo dokladnie trafic w te same pixele , stad teoretycznie udaje sie uzyskac poprawe rozdzielczosci obrazowania .

kwestia software jak te obrazy ze soba polaczyc. Na razie stosuje sie do wyraznej redukcji szumu i przy okazji prawiei , ze niezauwazalnej poprawy rodzielczosci.

Tak wlasnie robiono w laboratoriach w czasach analogu. Probleme bylo pokrycie zdjec.

metoda z przesunieciem o pol pixela bedzie chyba efektywniejsza w praktyce.

a uświadamiacie sobie sobie jaki byłby śmiech gdyby producent smartfona opowiedział o nowej ekscytującej funkcji podniesienia rozdzielczości pod warunkiem że wgramy do komputera i specjalnym oprogramowaniem połączymy 16 ujęć? i to jest sony które jakoby przoduje w innowacjach, zobaczcie jakie zacofanie technologiczne jest w tej branży :-|

@szuu

"i to jest sony które jakoby przoduje w innowacjach, zobaczcie jakie zacofanie technologiczne jest w tej branży"

A w którym smartfonie masz kontrolowane przesuwanie matrycy? Czy też nie rozumiesz o co chodzi?

Pytanie pomocnicze, kto jest głównym dostawca modułów foto do tych smartfonów?

no nie żartuj, w smartfonach stosuje się normalną stabilizację optyki a nie jakieś protezy w postaci przesuwania matrycy.

a jeżeli producentem jest unitra to co to zmienia w kwestii zacofania branży fotograficznej i tego że smartfon potrafi to co aparat za 18 tys. może będzie potrafił za 5 lat? moduł foto jest tylko jednym z elementów urządzenia do robienia zdjęć.

szuu

18 lipca 2019, 10:39

a uświadamiacie sobie sobie jaki byłby śmiech gdyby producent smartfona opowiedział o nowej ekscytującej funkcji podniesienia rozdzielczości pod warunkiem że wgramy do komputera i specjalnym oprogramowaniem połączymy 16 ujęć? i to jest sony które jakoby przoduje w innowacjach, zobaczcie jakie zacofanie technologiczne jest w tej branży :-|

----------------

jest roznica

w komorkach stosuje sie to w celu ratowania slabych zdjec

w sony w celu dalszej poprawy dobrych zdjec.

tzw " fotografia obliczeniowa" polega na tym , ze liczy sie na to, iz dostanie sie z komorki takie zdjecie jak z duzej matrycy.

sa rozne metody podnoszenia rozdzielczosci i nie chce sie na ich temat wypowiadac , ani tez nie chce przekazywac moich osobistych doswiadczen jako jedynie slusznych.

osobiscie wole matryce o wiekszych pixelach , czyli mniejszej rozdzielczsoci a jesli trzeba to podnosic rozdzielczosc wydluzaniem ogniskowej. Jest to chyba i szybciej i latwiej. Jesli mam zrobic 16 zdjec i je skladac zeby podniesc rozdzielczosc dwukrotnie ( nawet calkowicie automatycznie ) , to od razu robie dwa zdjecia dluzsza ogniskowa i je skladam. Dla takich operacji motyw i tak musi byc nieruchomy.

Jest obejscie do pixelshift , od lat , calkiem niezle , wiec nie tesknie.

@szuu

"no nie żartuj, w smartfonach stosuje się normalną stabilizację optyki a nie jakieś protezy w postaci przesuwania matrycy"

Po pierwsze stabilizacja optyki trafiła do smartfonów właśnie z branży foto, więc pisanie w tym kontekście o zacofaniu tejże tylko potwierdza twoje nierozumienie tematu. Po drugie Sony oprócz stosowania stabilizacji matrycy stosuje również stabilizację optyczną. Po trzecie w tym wypadku ruchy matrycy są stosowane w innym celu i jeszcze raz zapytam, który smartfon potrafi ruszać matrycą o 1 czy 0,5 piksela celem chociażby uzyskania pełnego RGB w jednym punkcie i/lub podniesienia rozdzielczości plików?

no właśnie, przecież to nie komórka i można założyć inny obiektyw ale jednak wymyślili to łączenie.

więc po co? wygoda! w teorii robimy jeden pstryk i już mamy lepszą rozdzielczość z tego samego obiektywu, ale jednak w praktyce jest pod górkę bo aparat nie daje rady tego wykonać. i to jest właśnie zacofanie.

podobnie dawniej była w aparatach funkcja tylko bracketingu ale bez łączenia zdjęć. dzisiaj jakiś hdr jest już w aparatach choć znowu z powodu zacofania, działa gorzej niż w telefonach. i potem są pytania na forach czemu ajfon zrobił mi lepsze zdjęcie niż profesjonalna lustrzanka canon bo nie niebo nie jest przepalone.

a 10 lat temu pytanie byłoby odwrotne!

nie kłócę się, że telefony zawsze robią lepsze zdjęcia :P tylko że im bardziej telefony stają się podstawowym narzędziem fotograficznym tym bardziej rzucają się w oczy niedostatki aparatów spowodowane (między innymi) ograniczoną mocą obliczeniową.

Zacofania? Nie masz pojęcia o technologii.

@Pokoradlasztuki

Zgaduję, że nadpróbkowanie (oversampling - patrz np. wiki) jest stosowane w celu zmniejszenia szumów przy długich czasach naświetlania. Funkcję tą można włączyć lub wyłączyć. Czas sczytywania matrycy jest dość długi i przy wielokrotnym skanowaniu odpowiednio przedłuża się.

@szuu

"no właśnie, przecież to nie komórka i można założyć inny obiektyw ale jednak wymyślili to łączenie. "

Napisz miszczu, jakim sposobem sprawisz, aby założenie innego obiektywu dało pełną informację o kolorze w każdym punkcie obrazu? Bo to było pierwotne przeznaczenie funkcji pixel shift u Pentaksa i Sony, która u tego drugiego została rozszerzona o dodatkowe przesunięcia matrycy celem podniesienia rozdzielczości wyjściowej plików.

"ale jednak w praktyce jest pod górkę bo aparat nie daje rady tego wykonać. i to jest właśnie zacofanie. "

A po czym wnosisz, że nie daje? Podpowiem ci też, że w telefonie mam funkcję składania zdjęć (aczkolwiek nie powstałych wskutek przesunięć matrycy) i też ów "nowoczesny" telefon miewa z tym problemy.

"tym bardziej rzucają się w oczy niedostatki aparatów spowodowane (między innymi) ograniczoną mocą obliczeniową."

Bredzisz.

barnaba

18 lipca 2019, 12:40

@Pokoradlasztuki

Zgaduję, że nadpróbkowanie (oversampling - patrz np. wiki) jest stosowane w celu zmniejszenia szumów przy długich czasach naświetlania. Funkcję tą można włączyć lub wyłączyć. Czas sczytywania matrycy jest dość długi i przy wielokrotnym skanowaniu odpowiednio przedłuża się

------------------

poniewaz szum ma charketer absolutnie przypadkowy , wiec robiac kilka kolejnych zdjec te same punkty obrazowe beda roznic sie luminancja.

nie jest mozliwe rozdzielenie szumu od sygnalu , tzn nie wiadomo na ile ta lumionancja jest spowodowana szumem a na ile sygnalem.

ale roznice pomiedzy kolejno naswietlonymi punktami wynikaja z roznic szumu.

Czyli fluktuacje sa spowodowane szumem.

usredniajac luminacje , usredniamy szum i sygnal . Sygnal jest na kazdym zdjeciu ten sam wiec srednia bedzie ta sama , srednia szumu bedzie nizsza od maksimum. dzieki temu uzyskuje sie spadek poziomu szumu.

troche inaczej jest z rozdzielczoscia , to bylo juz stosowane w fotografii analogowej , ale w warunkach domowych bardzo trudne do przeprowadzenia.

fotografowano Serie zdjec tego samego obiektu , nie zmieniajac polozenia aparatu . negatywy mozna bylo zlozyc ( to byl Problem ) . Usrednil sie szum ( ziarno ) , ale wskutek pewnej przypadkowosci poszczegolnych ujec na kilku zdjeciach uzyskano lacznie wiecej informacji. Zdjecia miedzy soba sie minimalnie roznily. Zdjecie zlozone bylo suma informacji z pojedynczych zdjec . Jesli na kilku zdjeciach ten sam punkt obrazowy sie powtarzal , to oczywiscie w wyniku byl to jeden ten sam punkt , ale na niektorych obrazach byly zarejestrowane punkty , ktorych nie bylo na innych , wlasnie wskutek przypadkowosci , kadry nie byly jednak absolutnie identyczne. Ostatecznie po zlozeniu obraz zawiertal wiecej detalu niz kazde ze zdjec pojedynczych.

w tym aparacie stosowane jest przesuniecie o polowe odleglosci miedzy pixelami , dzieki czemu zwieksza sie rozdzielczosc przy zachowaniu tej samej wielkosci pixeli ( zaleta). Oprocz tego przez przesuniecie 4 razy o jeden Pixel udaje sie uniknac interpolacji RGB. W sumie uzysk na rozdzielczosci , mozliwy jest takze na szumach.

Tu jest błąd:

Aparat oferuje rozdzielczość 4K bez przycięcia obrazu. W trybie Super 35 mm (1.5x crop) mamy do czynienia z odczytem wszystkich pikseli

Tam nie ma cropa albo można powiedzieć crop 1.0

Jak widze a7r3 to byl (i jest) dalej dobry zakup. A7r4 niczym nie imponuje (mi). Moze w praktyce wyjda jakies wartosciowe roznice, ale na razie wyglada mi to na porazke. Ot, wieksza rozdzielczosc, dla tych komu 42mpix nie wystarcza. Tyle, ze ta rozdzielczosc wzrosla bardzo nieznacznie, 20%.

A a7r3 kosztuj 10k w sklepie, gdy czroka to 17k. Sensu brak. Sony sie pospieszylo, mogli poczekac i wypuscic cos fajniejszego, ale w sumie nie przeszkadza mi to, bo porzucam mysli o upgrade bez zadnego zalu czy glebszego zastanowienia.

@komisarz_ryba:

- rozdzielczość wzrosła o 45%

- A7RIII w momencie premiery kosztował 15000 zł.

>>Trzeba przyznać, że Sony poważnie podeszło do trybu filmowania w A7R IV...

@magix

Raczej nikt poważnie stawiający tylko na filmowanie go nie kupi.

Ciekawe jak te Sony wypadnie na tle nowych bezlusterkowców Canona